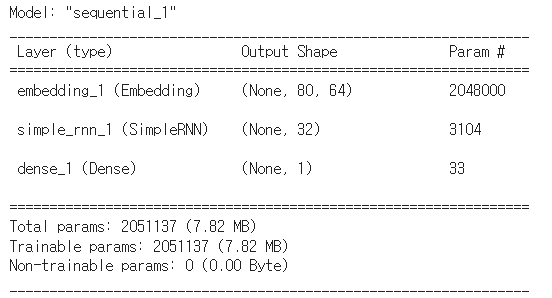

LLM (Large Language Model): 대규모 언어 모델로, 수많은 파라미터를 가진 인공 신경망으로 구성된 언어 모델. - 방대한 데이터 세트를 학습하기에 "대규모"라는 이름이 붙음- Transformer 신경망 아키텍처 기반- tuning을 통해서 추가 학습이 이루어지며 프로그래머가 원하는 특정 작업에 맞게 조정- 학습 데이터에 기반해서 답변을 생성하기 때문에 편향적 답변이나 환각 현상 발생 가능성 높음 ※ Transformer 모델- 기존 RNN, LSTM, GRU와 달리 셀프 어텐션이라는 메커니즘을 도입- 병렬 처리가 가능하며 문장의 모든 단어를 동시에 처리가 가능- 장거리 의존 문제 해결: 셀프 어텐션 메커니즘으로 문장 내 모든 단어 간의 관계를 직접 계산- 문맥을 고려해서 단어의 의..